24 juillet 2023

– 3 minutes de lecture

Armand-Julien Bitalika

Consultant Senior Transformation Data

Les étapes pour réussir son projet de Data Visualisation

24 juillet 2023

– 3 minutes de lecture

Armand-Julien Bitalika

Consultant Senior Transformation Data

Quoi de nouveau dans la version 6 de SAFe pour le système architecte ?

11 juillet 2023

– 5 minutes de lecture

Salomé Culis

Consultante Architecture

Cet article est le premier d’une série présentant les évolutions des rôles des différents architectes dans la nouvelle version du framework SAFe.

Nous allons donc voir en détail les différences pour le System Architect, en particulier sur les sujets d’interactions avec les autres parties prenantes et les responsabilités du System Architect.

Un premier point qu’il est important de souligner est le changement de nom de cet acteur lors du passage à la version 6 du framework. Celui-ci passe de “System Architect / Engineering” à “System Architect”, tout simplement.

Cela permet d’éviter une éventuelle confusion avec le Release Train Engineer ou même avec certains concepteurs fonctionnels qui sont plus proches d’un rôle de PO.

Mais ce changement de nom cache un changement beaucoup plus profond du rôle et de la posture de l’architecte système.

Dans cette nouvelle version du framework, la notion de collaboration est mise en exergue comme une compétence clé de l’architecte.

En effet, l’architecte système collabore avec différents groupes de parties prenantes :

Ainsi, l’architecte système doit être capable de travailler avec des acteurs très variés, de les aider à remplir leur rôle et de partager sa vision de l’architecture afin que le Train avance dans la bonne direction.

Nous voyons ici apparaître une notion de base de l’agilité, présente dans le manifeste agile (que vous avez tous sur votre table de nuit ou encadré au-dessus de votre bureau, j’en suis certaine !).

Cette nouvelle version du framework positionne très clairement l’architecte système comme un acteur qui sort de la tour de verre de l’architecture et va s’intégrer au quotidien dans les équipes.

A titre personnel, en tant qu’architecte sur un programme de refonte de la relation client, j’avais fait le choix d’aller m’installer dans l’open space avec les équipes agiles. Cela permettait de :

Au-delà des aspects cités précédemment, je me suis ainsi sentie comme faisant partie du projet à part entière. Je m’étais bien sûr assurée de garder une proximité forte avec mes collègues architectes (nécessaire pour s’aligner aux différents niveaux si vous avez bien suivi !).

Vous vous dites peut-être que l’architecte système échange avec beaucoup d’acteurs. Et vous vous demandez peut-être en quoi consiste véritablement son rôle.

En effet, son rôle évolue pour assumer les responsabilités ci-dessous :

Les deux derniers points notamment impliquent un véritable changement d’état d’esprit. Le travail de l’architecte ne s’arrête pas au moment de la présentation de la Vision d’Architecture, il doit continuer à accompagner le Train opérationnellement au quotidien pour pouvoir remplir l’ensemble de ces responsabilités.

Auparavant définies sous la forme d’une liste à la prévert, les tâches du System Architect deviennent à présent un nombre limité de responsabilités clés.

C’est un vrai shift pour la position de System Architect.

D’un architecte système qui s’assoit sur les “fauteuils pré-positionnés” par ceux qui ont défini le cadre de gouvernance SAFe, nous passons à un vrai acteur et “modeleur” de l’itération locale du framework SAFe.

Il n’est pas cantonné à des tâches définies de manière top-down, mais devient un acteur/décideur/influenceur du système.

Pour plus d’informations sur ces sujets et sur le rôle d’architecte dans un environnement agile, n’hésitez pas à aller voir notre série d’articles sur l’architecture et l’agilité.

Les articles 1 et 4 peuvent en particulier se révéler utiles :

Renforcer la culture data, de l'intérieur

28 juin 2023

– 3 min de lecture

Maureen Delaloi

Manager Transformation Data

Pour les entreprises qui sont confrontées à un virage vers le data driven, le fait de sous-estimer le besoin de changement organisationnel est souvent un problème plus important que les questions de technologie. Une entreprise peut disposer d’outils puissants et de données significatives, mais sans l’accompagnement et les processus appropriés pour mettre ces données entre les mains des bonnes personnes, l’extraction de la valeur peut s’avérer difficile.

Mettre en place une culture de l’apprentissage continu au sein de l’entreprise est un vrai levier de performance pour votre organisation et d’épanouissement de vos salariés.

Lorsque les données sont fondamentales pour la gestion de votre organisation, des analyses doivent être effectuées très rapidement au sein de toute votre organisation car elles sont essentielles à votre business.

L’idée des données en libre-service est la suivante : plutôt que d’engager un nombre infini de talents hautement qualifiés en data, pourquoi ne pas employer votre capital intellectuel et votre capital humain existant au sein votre organisation et leur donner les moyens de faire leur propre travail d’analyse des données ? Dans un système en libre-service, les différents métiers de votre organisation et les analystes peuvent accéder et travailler directement avec les données et leur visualisation. Ils sont aidés par des experts data, mais sans en dépendre, pour effectuer leur travail. C’est l’essor des “citizen data scientist”.

Ce type de programme permet aux entreprises de supprimer les frontières techniques et donne aux collaborateurs la possibilité d’utiliser leur propre expertise en la matière – après tout, ils connaissent mieux les problèmes auxquels ils s’attaquent, et ils savent de quelles données ils ont besoin – pour générer des idées et exécuter leur travail.

Les données en libre-service et la gouvernance vont certainement de pair. Il y a un équilibre délicat à trouver dès le départ. Vous devez protéger les utilisateurs et l’entreprise, vous assurer que vous êtes en conformité et que vous respectez les règlements, et permettre une meilleure compréhension des données. Mais en même temps, vous ne voulez pas être un obstacle tel que les gens ne puissent pas faire leur travail.

Le catalogage des données, la traçabilité des données et la mise en place d’un cadre d’utilisation (rôles, responsabilités, process, etc.) autour des données sont des éléments clefs de la gouvernance, car les collaborateurs doivent disposer des bonnes informations et du bon contexte concernant les données qu’ils consultent pour réussir.

Ce paragraphe ne concerne pas uniquement vos enjeux data, mais peut répondre à la question plus globale de l’organisation apprenante.

Établissez les bonnes bases culturelles en plaçant l’apprentissage au centre de votre organisation. Une organisation apprenante ne peut voir le jour que dans le cadre d’une culture d’intégration, de confiance, de collaboration et de leadership engagés sur le lieu de travail. Le changement cela ne se décrète pas. Donnez à votre équipe l’espace et le temps de réfléchir, de prendre du recul et de travailler sur leurs idées. Créez une culture de travail personnalisée et adaptée, qui accueille la dissidence, récompense la créativité et sollicite des avis extérieurs pour améliorer la prise de décision globale.

In fine ces bonnes pratiques d’acculturation data en interne et de gouvernance des données vous aideront à répondre à une solution simple à fort potentiel : au lieu de trouver un objectif pour les données, trouvez des données pour un objectif. Cela vous permet de piloter vos données comme des actifs précieux au service des besoins métiers à valeur !

Pour aller plus loin,

Transformation Data-driven :

SUV et Numérique : Les 2 fléaux environnementaux de l'ère moderne

26 mai 2023

– 7 minutes de lecture

Pascal Ly

Consultant Senior Architecture

Note préalable à la lecture : ce billet d’humeur est une cascade réalisée par un professionnel de la boutade, n’essayez pas de tout interpréter au premier degré.

Tyre Extinguishers, Extinction Rebellion, dégonfleurs de pneus, si vous n’avez jamais entendu parler de la nouvelle mode des activistes sur ces derniers mois, c’est que vous êtes à côté de la plaque !

L’objectif de ces collectifs est simple : dégonfler un ou plusieurs pneus des 4×4 et SUV pour sensibiliser les propriétaires de ces véhicules contre la pollution et le réchauffement climatique, et les inciter à favoriser les transports en commun.

Pour mener leurs actions en toute discrétion, les militants écologistes agissent habituellement la nuit, en arpentant les rues des grandes villes en quête de pneus à dégonfler. Grâce à une méthode bien rodée, ils s’attardent peu sur une voiture et partent sur les chapeaux de roues quand ils se sentent surveillés ou lorsqu’ils sont démasqués.

Le lendemain, les propriétaires constatent, impuissants, que leurs véhicules ont été la cible de ces justiciers noctambules. Ils découvrent un tract apposé sur leurs pare-brises qui explique la démarche du collectif, mais également pour dénoncer la pollution de ces tanks en milieu urbain.

« Ne le prenez pas personnellement. Vous n’êtes pas notre cible, c’est votre véhicule »

Le message semble clair : le propriétaire n’a rien à se reprocher dans cette histoire et inutile de monter dans les tours.

Seulement voilà, le désagrément, lui, est bien présent et a de quoi irriter le conducteur qui doit utiliser son véhicule au moment de la découverte du message.

Comment l’automobiliste peut-il bien accepter cet « acte de sensibilisation » au moment où il doit prendre le volant pour son besoin professionnel ou personnel ?

Difficile de prendre parti pour cette cause juste lorsque vous vous sentez victime d’une injustice… Bien au contraire, la réaction sera bien souvent à l’opposé de l’effet attendu : le propriétaire aura de quoi péter une durite et se désintéresser des conséquences de sa voiture sur un plan écologique !

Certes, les SUV trustent le podium en termes d’émissions mondiales de CO2 car le nombre de véhicules en circulation ne cessent d’augmenter. Mais il est aussi important de rappeler que les voitures de sport et berline de luxe peuvent polluer jusqu’à 2 fois plus que les plus gros SUV.

En toute logique, les ardents défenseurs de l’écologie devraient poursuivre leurs activités en allant également dégonfler les pneus des jets privés ou siphonner le carburant des yachts privés, sans oublier de déposer le message de sympathie sur les vitres !

Il semblerait que dégonfler les pneus des véhicules ne soit pas suffisant pour retirer les SUV du catalogue des constructeurs automobiles. Au contraire, les SUV sont devenus les chouchous des Français, et représentent près de la moitié des ventes de véhicules neufs.

S U V, 3 lettres qui divisent un monde et qui font débat, à tort ou à raison.

Le militantisme bruyant est-il la seule façon de sensibiliser à la lutte contre le réchauffement climatique ?

Les actions individuelles ne pourraient-elles pas également avoir un impact significatif sur la réduction de notre empreinte environnementale ?

Trier les déchets, consommer localement, privilégier les moyens de transport moins polluants, acheter des produits recyclés ou réutilisables, et réduire leur consommation globale : ces gestes modestes, cumulés, ont un impact significatif sur l’environnement.

Plutôt que de pointer du doigt les autres, nous pourrions tous agir de manière responsable pour réduire notre empreinte environnementale et contribuer à la lutte contre le réchauffement climatique. Il ne s’agit pas de juger les actions des uns et des autres, mais plutôt de promouvoir une prise de conscience collective, à commencer par son entourage, qui encouragera chacun à agir selon ses convictions et ses moyens pour préserver notre planète.

En particulier, il est intéressant de noter que l’utilisation croissante des objets numériques dans notre vie quotidienne a également un impact significatif sur l’environnement.

L’arrivée d’Internet dans nos foyers a marqué une véritable révolution numérique, et aujourd’hui, il est rare de trouver une personne qui n’a jamais été en contact avec une technologie numérique (vous visualisez bien vos grands-parents avec une tablette multimédia ?).

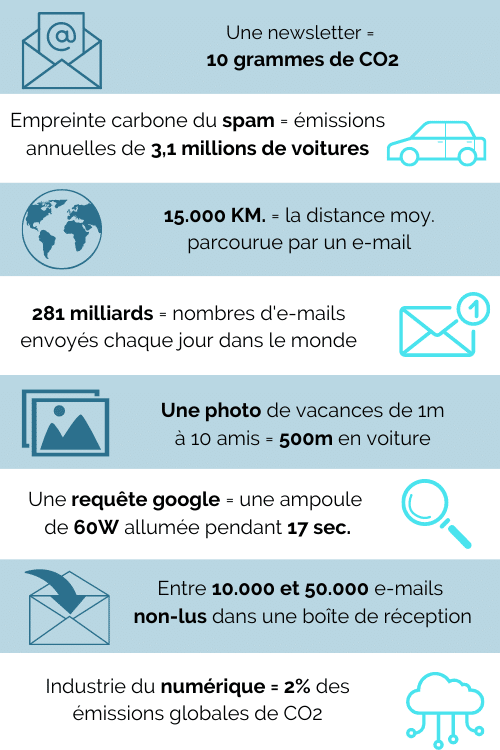

En 2022, Google enregistre plus de 8,5 milliards de requêtes par jour, générant ainsi un coût énergétique non négligeable à l’échelle mondiale.

Ce Cloud-là n’est pas composé de petites gouttelettes d’eau ou de cristaux de glace, mais plutôt de racks de serveurs et d’infrastructures techniques nécessaires pour les héberger.

Malheureusement, l’utilisation croissante d’objets numériques a un impact significatif sur l’environnement.

Selon l’organisation Carbon Literacy Project, un email génère entre 0,03 g et 26 g de CO2 sans prendre en compte les pièces jointes.

Le cabinet d’études Radicati Group a révélé que chaque jour, en 2022, 333 milliards d’emails ont été envoyés dans le monde entier.

En prenant une moyenne basse de 4 g de CO2 par email, cela représente environ 486 millions de tonnes de CO2 générés pour cette année.

Imaginez l’empreinte carbone que peut générer un appel personnel ou professionnel en visioconférence !

Par ailleurs, une étude de l’ADEME a démontré que la fabrication d’un ordinateur pesant 2 kg mobilise 800 kg de matières premières, et génère 124 kg de CO² sur un total de 169 kg émis tout au long de son cycle de vie.

À partir de cette constatation, il est facile de comprendre que limiter le remplacement fréquent de nos objets électroniques, tels que les ordinateurs, les téléphones portables ou les téléviseurs, permet de réduire leur impact environnemental.

Ensemble, réfléchissons à notre façon de consommer et prenons conscience de l’impact de nos utilisations quotidiennes des technologies numériques.

Il est important de se demander si nous avons réellement besoin de posséder plusieurs modèles d’appareils différents qui risquent souvent d’être laissés de côté.

Alors, prêt à évangéliser cette pratique autour de vous et à faire de la place dans vos placards ?

Pascal, podomobiliste chevronné et fervent croyant de la sobriété numérique

RH et Data Privacy (RGPD) : les 3 points clés à respecter

3 mai 2023

– 8 min de lecture

Louis Allavena

Consultant Transformation Data

Depuis quelque temps, la question de la conformité interne prend une place indéniable dans les entreprises. En effet, même si le RGPD est un règlement datant de 2018, l’attention a été portée aux données clients, aux besoins des équipes marketing, data ou digital et fournisseurs, délaissant de fait les données RH des organisations.

Une conformité RGPD permet cependant d’améliorer l’image employeur de son entreprise (pour les employés mais aussi pour les candidats) au travers du respect de la confidentialité et de la gestion des risques sur la vie privée, par une politique de protection des données.

De plus, c’est un moyen d’améliorer la gestion des employés et de mettre à la disposition du DRH, des informations à jour, complètes et centralisées qui permettront d’améliorer la prise de décision et de planification des ressources humaines.

Enfin, c’est aussi un moyen d’éviter à l’entreprise des sanctions financières et des poursuites en cas de violation des données des employés, sans compter les conséquences sur la réputation de l’entreprise.

Cet article a pour but de donner quelques conseils aux équipes RH et aux consultants. J’ai procédé à un exercice de collecte d’informations qui, je l’espère, vous sera utile pour vous guider dans votre mise en conformité.

Cependant, je n’aborderai pas tous les sujets nécessaires pour se mettre complètement en conformité, mais uniquement les points récurrents qui me sont souvent demandés.

Chaque traitement de données personnelles doit respecter une base légale.

Parce qu’il n’est pas nécessaire de réinventer la roue et que la CNIL a fait un excellent travail de présentation des bases légales envisageables pour les activités de traitements spécifiques à la gestion des ressources humaines, je vous propose ce tableau :

| Activités de traitement | Finalités | Bases légales envisageables (sous réserve de choix différents justifiés par un contexte spécifique) |

| Recrutement | Traitement des candidatures (CV et lettre de motivation) et gestion des entretiens | Mesures précontractuelles |

| Constitution d’une CV-thèque | Intérêt légitime | |

| Gestion administrative du personnel | Gestion du dossier professionnel des employés, tenu conformément aux dispositions législatives et réglementaires, ainsi qu’aux dispositions statutaires, conventionnelles ou contractuelles qui régissent les intéressés. | Exécution du contrat |

| Réalisation d’états statistiques ou de listes d’employés pour répondre à des besoins de gestion administrative. | Intérêt légitime | |

| Gestion des annuaires internes et des organigrammes. | Intérêt légitime | |

| Gestion des dotations individuelles en fournitures, équipements, véhicules et cartes de paiement. | Intérêt légitime | |

| Gestion des élections professionnelles. | Obligation légale | |

| Organisation des réunions des instances représentatives du personnel. | Obligation légale | |

| Gestion des rémunérations et accomplissement des formalités administratives | Etablissement des rémunérations, mise à disposition des bulletins de salaire | Exécution du contrat |

| Déclaration sociale nominative. | Obligation légale | |

| Mise à disposition des personnels d’outils informatiques | Suivi et maintenance du parc informatique. | Intérêt légitime |

| Gestion des annuaires informatiques permettant de définir les autorisations d’accès aux applications et aux réseaux. | Intérêt légitime | |

| Mise en œuvre de dispositifs destinés à assurer la sécurité et le bon fonctionnement des applications informatiques et des réseaux. | Intérêt légitime | |

| Gestion de la messagerie électronique professionnelle. | Intérêt légitime | |

| Réseaux privés virtuels internes à l’organisme permettant la diffusion ou la collecte de données de gestion administrative des personnels (intranet). | Intérêt légitime | |

| Organisation du travail | Gestion des agendas et projets professionnels. | Intérêt légitime |

| Suivi des carrières et de la mobilité | Évaluation professionnelle des personnels, dans le respect des dispositions législatives, réglementaires ou conventionnelles qui la régissent. | Intérêt légitime |

| Gestion des compétences professionnelles internes. | Intérêt légitime | |

| Gestion prévisionnelle de l’emploi et des compétences (GPEC) | Intérêt légitime | |

| Gestion de la mobilité professionnelle. | Exécution du contrat | |

| Formation | Gestion des demandes de formation et des périodes de formation effectuées. | Exécution du contrat |

| Organisation des sessions de formation et évaluation des connaissances et des formations. | Intérêt légitime | |

| Gestion des aides sociales | Gestion de l’action sociale et culturelle directement mise en œuvre par l’employeur, à l’exclusion des activités de médecine du travail, de service social ou de soutien psychologique. | Intérêt légitime |

Les données personnelles ne pouvant pas être conservées à vie, il est nécessaire de mettre en place des purges automatisées ou non (selon la taille de vos espaces de stockage, il est parfois indispensable de passer par une purge automatisée).

Les durées de conservations sont généralement à définir par le métier, selon son besoin (la personne utilisant la donnée ou la collectant) ; dans votre cas : le DRH ou le responsable administratif en collaboration avec votre DPO ou le référent RGPD de votre organisation. Cependant, certains documents doivent respecter des durées légales de conservation déjà prévues par le droit.

Le tableau ci-dessous vous permet d’avoir une liste (non exhaustive) des documents les plus souvent demandés/collectés en interne :

| Activités de traitement | Détails du traitement | Base active | Archivage intermédiaire | Textes de référence |

| Gestion de la paie | Bulletin de salaire | 1 mois | 5 ans | L. 3243-4 du code du travail |

| Bulletin de salaire | 1 mois | 50 ans (en version dématérialisée) | D. 3243-8 du code du travail | |

| Eléments nécessaires au calcul de l’assiette | 1 mois | 6 ans | L. 243-16 du code sécurité sociale | |

| Saisie des données calculées (DSN) | Le temps nécessaire à l’accomplissement de la déclaration | 6 ans | L. 243-16 du code sécurité sociale | |

| Ordre de virement pour paiement | Le temps nécessaire à l’émission du bulletin de paie | 10 ans à compter de la clôture de l’exercice comptable | L. 123-22 du code du commerce | |

| Registre unique du personnel | Ordre de virement pour paiement | La durée pendant laquelle le salarié fait partie des effectifs | 5 ans à compter du départ du salarié de l’organisme | R. 1221-26 du code du travail |

| Gestion des mandats des représentants du personnel | Nature du mandat et syndicat d’appartenance | 6 mois après la fin du mandat | 6 ans (prescription pénale pour délit) | L. 2411-5 du code du travail |

| Les données relatives aux sujétions particulières ouvrant droit à congés spéciaux ou à crédit d’heures de délégation (ex: exercice d’un mandat électif ou représentatif syndical) | Le temps de la période de sujétion de l’employé concerné | 6 ans (prescription pénale pour délit) | L. 2142-1-3 du code du travail |

La gestion des droits des personnes est une obligation sur toutes les données personnelles, il faut donc prendre en compte le processus de réponse à ces demandes. Les droits sont : le droit d’accès (avoir une copie des données personnelles), le droit de suppression (demander la suppression de tout ou partie de ses données personnelles), le droit de modification (demander la modification de ses données personnelles en cas d’erreur), le droit de portabilité (demander une copie sous format lisible par une machine (ex. : csv) de ses données personnelles), le droit de limitation (demander la non utilisation de ses données personnelles pour un traitement spécifique).

Des règles simples sont à respecter :

Pour bien commencer, il est important d’avoir une équipe dédiée à la conformité, en complément du DPO et du DRH qui sont indispensables. Cette équipe devra être formée et aura des rôles précis. Cette formation peut se faire directement par le MOOC de la CNIL, régulièrement mis à jour, qui est complet et qui donne de très bonnes bases (testé et approuvé par mon équipe).

En interne, il est indispensable de pouvoir sensibiliser les collaborateurs sur leurs droits (droits des personnes, bases légales, limitations, …), mais aussi leurs devoirs vis-à-vis des données personnelles qu’ils traitent (sécurité des postes de travail, sécurité des documents, politique de mot de passe, …).

Enfin et afin de pouvoir être totalement conforme, il est nécessaire de créer un registre de traitement, de faire une revue des process de gestion des droits des personnes, d’analyser les applications internes, les contrats de sous-traitance et les mesures de sécurité de la DSI. Il est également nécessaire de s’assurer du bon fonctionnement des purges et archivages ou encore de mettre en place des analyses d’impacts sur la vie privée et des audits.

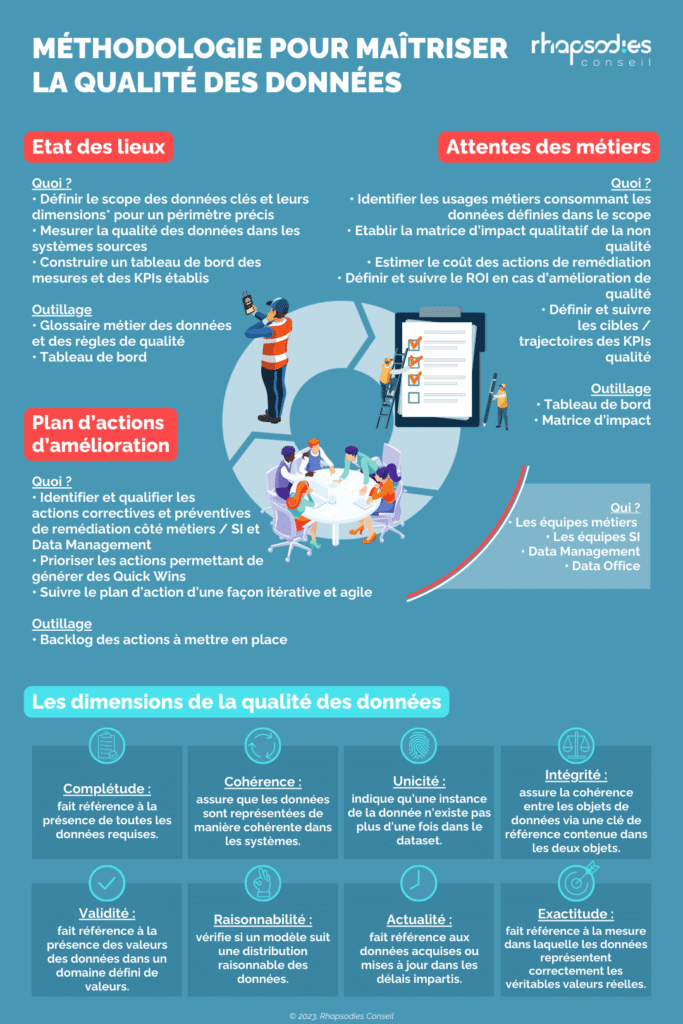

Comment piloter la qualité de vos données ?

18 avril 2023

– 2 min de lecture

Zied Ben Khalifa

Consultant Transformation Data

Qui ?

Quoi ?

Outillage

Quoi ?

Outillage

Quoi ?

Outillage